Przetestuj SWOJĄ Firmę w Minuty

Utwórz konto i uruchom swojego chatbota AI w kilka minut. W pełni konfigurowalny, bez konieczności kodowania - zacznij angażować swoich klientów natychmiast!

Magia za oknem czatu

Pozorna prostota współczesnych chatbotów maskuje niesamowicie wyrafinowaną technologicznie orkiestrę grającą za kulisami. To, co wygląda jak prosta wymiana tekstu, obejmuje wiele wyspecjalizowanych systemów AI działających wspólnie: przetwarzających Twój język, pobierających istotne informacje, generujących odpowiednie odpowiedzi i nieustannie uczących się na podstawie interakcji.

Jako osoba, która spędziła lata na rozwijaniu i wdrażaniu systemów chatbotów dla różnych branż, miałem okazję obserwować ich niezwykłą ewolucję z pierwszej ręki. Wielu użytkowników jest zaskoczonych, dowiadując się, że współczesne chatboty nie są pojedynczymi programami AI, ale raczej złożonymi ekosystemami wyspecjalizowanych komponentów współpracujących ze sobą. Zrozumienie tych komponentów nie tylko demistyfikuje to, co czasami może wydawać się technologiczną magią, ale także pomaga nam lepiej docenić zarówno ich możliwości, jak i ograniczenia.

W tej eksploracji odsłonimy kulisy nowoczesnych chatbotów, aby zrozumieć kluczowe technologie, które je napędzają, sposób, w jaki te systemy są szkolone i jak pokonują podstawowe wyzwania języka ludzkiego. Niezależnie od tego, czy rozważasz wdrożenie chatbota dla swojej firmy, czy po prostu jesteś ciekawy technologii, z którą codziennie wchodzisz w interakcję, ta wycieczka za kulisy zapewni cenne spostrzeżenia na temat jednej z najbardziej widocznych aplikacji AI.

Podstawy: Duże modele językowe

Skala tych modeli jest trudna do pojęcia. Największe LLM mają setki miliardów parametrów – regulowanych wartości, których model używa do tworzenia przewidywań. Podczas treningu parametry te są stopniowo udoskonalane, ponieważ model przetwarza ogromne zestawy danych składające się z książek, artykułów, stron internetowych, repozytoriów kodów i innych tekstów – często liczących biliony słów.

Dzięki temu procesowi treningu modele językowe rozwijają statystyczne zrozumienie tego, jak działa język. Uczą się słownictwa, gramatyki, faktów o świecie, wzorców rozumowania, a nawet pewnego stopnia zdrowego rozsądku. Co ważne, nie zapamiętują po prostu swoich danych treningowych – uczą się uogólnialnych wzorców, które pozwalają im obsługiwać nowe dane wejściowe, których nigdy wcześniej nie widziały.

Gdy wysyłasz wiadomość do chatbota obsługiwanego przez LLM, Twój tekst jest najpierw konwertowany na reprezentacje numeryczne zwane tokenami. Model przetwarza te tokeny przez wiele warstw połączeń neuronowych, ostatecznie tworząc rozkłady prawdopodobieństwa dla tego, które tokeny powinny pojawić się jako następne w odpowiedzi. Następnie system konwertuje te tokeny z powrotem na tekst czytelny dla człowieka.

Najbardziej zaawansowane modele językowe obejmują obecnie:

GPT-4: Model OpenAI obsługuje ChatGPT i wiele innych aplikacji komercyjnych, znanych ze swoich silnych możliwości rozumowania i szerokiej wiedzy.

Claude: Rodzina modeli Anthropic, zaprojektowana z naciskiem na pomocność, nieszkodliwość i uczciwość.

Llama 3: Modele o otwartej wadze Meta, które zdemokratyzowały dostęp do potężnej technologii LLM.

Gemini: Multimodalne modele Google, które mogą przetwarzać zarówno tekst, jak i obrazy.

Mistral: Rodzina wydajnych modeli, które zapewniają imponującą wydajność pomimo mniejszej liczby parametrów.

Pomimo ich niezwykłych możliwości, same modele języka bazowego mają znaczące ograniczenia jako agenci konwersacyjni. Nie mają dostępu do informacji w czasie rzeczywistym, nie mogą przeszukiwać sieci ani baz danych w celu weryfikacji faktów i często „halucynują” – generując wiarygodnie brzmiące, ale niepoprawne informacje. Ponadto bez dalszej personalizacji brakuje im wiedzy na temat konkretnych firm, produktów lub kontekstów użytkowników.

To dlatego nowoczesne architektury chatbotów integrują LLM z kilkoma innymi kluczowymi komponentami, aby tworzyć naprawdę użyteczne systemy konwersacyjne.

Generacja wzbogacona o wyszukiwanie: uziemienie chatbotów w faktach

Systemy RAG działają poprzez łączenie generatywnych możliwości modeli językowych z precyzją systemów wyszukiwania informacji. Oto, jak typowy proces RAG przebiega w nowoczesnym chatbocie:

Przetwarzanie zapytań: Gdy użytkownik zadaje pytanie, system analizuje je, aby zidentyfikować kluczowe potrzeby informacyjne.

Wyszukiwanie informacji: Zamiast polegać wyłącznie na danych szkoleniowych LLM, system przeszukuje odpowiednie bazy wiedzy – które mogą obejmować dokumentację firmy, katalogi produktów, często zadawane pytania, a nawet aktywną zawartość witryny internetowej.

Wybór odpowiednich dokumentów: System wyszukiwania identyfikuje najbardziej odpowiednie dokumenty lub fragmenty na podstawie podobieństwa semantycznego do zapytania.

Rozszerzenie kontekstu: Te pobrane dokumenty są dostarczane do modelu językowego jako dodatkowy kontekst podczas generowania odpowiedzi.

Generowanie odpowiedzi: LLM generuje odpowiedź, która obejmuje zarówno jego ogólne możliwości językowe, jak i konkretne pobrane informacje.

Atrybucja źródła: Wiele systemów RAG śledzi również, które źródła przyczyniły się do odpowiedzi, umożliwiając cytowanie lub weryfikację.

To podejście łączy w sobie to, co najlepsze z obu światów: zdolność LLM do rozumienia pytań i generowania języka naturalnego z dokładnością i aktualnymi informacjami z systemów wyszukiwania. Rezultatem jest chatbot, który może dostarczać konkretnych, faktycznych informacji o produktach, zasadach lub usługach bez uciekania się do halucynacji.

Rozważmy chatbota obsługi klienta e-commerce. Gdy zostanie zapytany o zasady zwrotów dla określonego produktu, czysty LLM może wygenerować brzmiącą wiarygodnie, ale potencjalnie niepoprawną odpowiedź na podstawie ogólnych wzorców zaobserwowanych podczas szkolenia. Chatbot ulepszony przez RAG zamiast tego pobrałby rzeczywisty dokument zasad zwrotów firmy, znalazłby odpowiednią sekcję dotyczącą tej kategorii produktów i wygenerował odpowiedź, która dokładnie odzwierciedla bieżącą politykę.

Wyrafinowanie systemów RAG stale się rozwija. Nowoczesne implementacje wykorzystują gęste osadzenia wektorowe do reprezentowania zapytań i dokumentów w wielowymiarowej przestrzeni semantycznej, umożliwiając wyszukiwanie na podstawie znaczenia, a nie tylko dopasowywania słów kluczowych. Niektóre systemy wykorzystują wieloetapowe kanały wyszukiwania, najpierw rzucając szeroką sieć, a następnie udoskonalając wyniki poprzez ponowne klasyfikowanie. Inne dynamicznie określają, kiedy wyszukiwanie jest konieczne, a kiedy LLM może bezpiecznie odpowiedzieć na podstawie swojej wiedzy parametrycznej.

W przypadku firm wdrażających chatboty skuteczna implementacja RAG wymaga przemyślanego przygotowania bazy wiedzy – organizowania informacji w pobieralne fragmenty, regularnej aktualizacji treści i strukturyzacji danych w sposób ułatwiający dokładne wyszukiwanie. Po prawidłowej implementacji RAG radykalnie poprawia dokładność chatbotów, szczególnie w przypadku aplikacji specyficznych dla danej domeny, w których precyzja ma kluczowe znaczenie.

Zarządzanie stanem konwersacyjnym: utrzymywanie kontekstu

Współczesne chatboty wykorzystują zaawansowane systemy zarządzania stanem konwersacji, aby utrzymać spójne, kontekstowe wymiany. Systemy te śledzą nie tylko jawną treść wiadomości, ale także ukryty kontekst, który ludzie naturalnie utrzymują podczas konwersacji.

Najbardziej podstawową formą zarządzania stanem jest śledzenie historii konwersacji. System utrzymuje bufor ostatnich wymian (zarówno danych wejściowych użytkownika, jak i własnych odpowiedzi), który jest dostarczany do modelu języka przy każdym nowym zapytaniu. Jednak w miarę wydłużania się konwersacji uwzględnienie całej historii staje się niepraktyczne ze względu na ograniczenia długości kontekstu nawet najbardziej zaawansowanych LLM.

Aby poradzić sobie z tym ograniczeniem, zaawansowane chatboty stosują kilka technik:

Podsumowanie: okresowe kondensowanie wcześniejszych części konwersacji do zwięzłych podsumowań, które przechwytują kluczowe informacje, jednocześnie zmniejszając wykorzystanie tokenów.

Śledzenie jednostek: jawne monitorowanie ważnych jednostek (osób, produktów, problemów) wspomnianych w trakcie konwersacji i utrzymywanie ich w ustrukturyzowanym stanie.

Świadomość etapu konwersacji: śledzenie, na jakim etapie przebiegu procesu znajduje się obecnie konwersacja – czy zbiera informacje, proponuje rozwiązania, czy potwierdza działania.

Trwałość kontekstu użytkownika: utrzymywanie istotnych informacji o użytkowniku w trakcie sesji, takich jak preferencje, historia zakupów lub dane konta (z odpowiednimi kontrolami prywatności).

Pamięć intencji: pamiętanie pierwotnego celu użytkownika nawet poprzez konwersacyjne objazdy i wyjaśnienia.

Rozważmy scenariusz obsługi klienta: użytkownik zaczyna pytać o uaktualnienie swojego planu subskrypcji, a następnie zadaje kilka szczegółowych pytań o funkcje, porównania cen i cykle rozliczeniowe, zanim ostatecznie zdecyduje się na uaktualnienie. Skuteczny system zarządzania stanem konwersacji zapewnia, że gdy użytkownik powie „Tak, zróbmy to”, chatbot dokładnie zrozumie, do czego odnosi się „to” (aktualizacja) i zachowa wszystkie istotne szczegóły z meandrującej konwersacji.

Techniczna implementacja zarządzania stanem różni się w zależności od platformy. Niektóre systemy wykorzystują podejście hybrydowe, łącząc symboliczne śledzenie stanu (jawne modelowanie jednostek i intencji) z ukrytymi możliwościami dużych okien kontekstowych w nowoczesnych LLM. Inne wykorzystują specjalistyczne moduły pamięci, które selektywnie pobierają odpowiednie części historii konwersacji na podstawie bieżącego zapytania.

W przypadku złożonych aplikacji, takich jak obsługa klienta lub sprzedaż, zarządzanie stanem często integruje się z modelowaniem procesów biznesowych, umożliwiając chatbotom prowadzenie konwersacji przez zdefiniowane przepływy pracy, zachowując jednocześnie elastyczność w celu zapewnienia naturalnej interakcji. Najbardziej zaawansowane implementacje mogą nawet śledzić stan emocjonalny wraz z kontekstem faktycznym, dostosowując styl komunikacji na podstawie wykrytego nastroju użytkownika.

Skuteczne zarządzanie kontekstem przekształca interakcje chatbotów z rozłączonych wymian pytań i odpowiedzi w autentyczne konwersacje, które opierają się na wspólnym zrozumieniu – krytycznym czynniku satysfakcji użytkownika i wskaźnikach ukończenia zadań.

Rozumienie języka naturalnego: interpretowanie intencji użytkownika

Nowoczesne systemy NLU w chatbotach zazwyczaj wykonują kilka kluczowych funkcji:

Rozpoznawanie intencji: Identyfikowanie podstawowego celu lub zamierzenia użytkownika. Czy użytkownik próbuje dokonać zakupu, zgłosić problem, poprosić o informacje lub coś innego? Zaawansowane systemy mogą rozpoznawać wiele lub zagnieżdżone intencje w jednej wiadomości.

Ekstrakcja encji: Identyfikowanie i kategoryzowanie określonych informacji w wiadomości użytkownika. Na przykład w „Muszę zmienić lot z Chicago do Bostonu w czwartek” encje obejmują lokalizacje (Chicago, Boston) i czas (czwartek).

Analiza sentymentów: Wykrywanie tonu emocjonalnego i nastawienia, co pomaga chatbotowi odpowiednio dostosować styl odpowiedzi. Czy użytkownik jest sfrustrowany, podekscytowany, zdezorientowany czy neutralny?

Identyfikacja języka: Określenie języka, którym posługuje się użytkownik, aby zapewnić odpowiednie odpowiedzi w środowiskach wielojęzycznych.

Podczas gdy wcześniejsze platformy chatbotów wymagały wyraźnego programowania intencji i jednostek, nowoczesne systemy wykorzystują wrodzone możliwości rozumienia języka LLM. Pozwala im to obsługiwać znacznie szerszy zakres wyrażeń bez konieczności wyczerpującego wyliczania możliwych fraz.

Gdy użytkownik wpisze „Proces realizacji transakcji zawiesza się na stronie płatności”, zaawansowany system NLU zidentyfikuje to jako intencję pomocy technicznej, wyodrębni „proces realizacji transakcji” i „stronę płatności” jako odpowiednie jednostki, wykryje frustrację w nastroju i przekieruje te informacje do odpowiedniej ścieżki generowania odpowiedzi.

Dokładność NLU znacząco wpływa na zadowolenie użytkownika. Gdy chatbot stale błędnie interpretuje żądania, użytkownicy szybko tracą zaufanie i cierpliwość. Aby zwiększyć dokładność, wiele systemów stosuje punktację zaufania – gdy pewność zrozumienia spada poniżej pewnych progów, chatbot może zadać pytania wyjaśniające zamiast kontynuować z potencjalnie błędnymi założeniami.

W przypadku aplikacji specyficznych dla domeny systemy NLU często włączają specjalistyczną terminologię i rozpoznawanie żargonu. Na przykład chatbot w służbie zdrowia byłby szkolony w rozpoznawaniu terminów i objawów medycznych, podczas gdy bot usług finansowych rozumiałby terminologię bankową i typy transakcji.

Integracja NLU z innymi komponentami jest kluczowa. Wyekstrahowane intencje i jednostki informują procesy pobierania, pomagają utrzymać stan konwersacji i kierują generowaniem odpowiedzi – służąc jako krytyczne ogniwo między tym, co mówią użytkownicy, a tym, co robi system.

Przetestuj SWOJĄ Firmę w Minuty

Utwórz konto i uruchom swojego chatbota AI w kilka minut. W pełni konfigurowalny, bez konieczności kodowania - zacznij angażować swoich klientów natychmiast!

Generowanie i optymalizacja odpowiedzi

W nowoczesnych systemach generowanie odpowiedzi zazwyczaj obejmuje kilka etapów:

Planowanie odpowiedzi: Określanie, jakie informacje uwzględnić, jakie pytania zadać lub jakie działania zasugerować na podstawie bieżącego stanu konwersacji i dostępnej wiedzy.

Wybór treści: Wybór konkretnych faktów, wyjaśnień lub opcji do przedstawienia z potencjalnie dużych zestawów odpowiednich informacji.

Strukturyzacja: Organizowanie wybranej treści w logicznej, łatwej do naśladowania sekwencji, która skutecznie odpowiada potrzebom użytkownika.

Realizacja: Konwersja zaplanowanej treści na naturalny, płynny język, który pasuje do pożądanego tonu i stylu chatbota.

Chociaż LLM-y mogą generować imponująco spójny tekst, niekontrolowane generowanie często prowadzi do problemów, takich jak nadmierna rozwlekłość, uwzględnianie nieistotnych informacji lub odpowiedzi, które nie są zgodne z celami biznesowymi. Aby rozwiązać te problemy, zaawansowane systemy chatbotów wdrażają różne techniki optymalizacji:

Szablony odpowiedzi: W przypadku typowych scenariuszy z przewidywalnymi potrzebami informacyjnymi wiele systemów używa sparametryzowanych szablonów, które zapewniają spójne, wydajne odpowiedzi, umożliwiając jednocześnie personalizację.

Kontrola długości: Mechanizmy dostosowujące długość odpowiedzi na podstawie złożoności zapytania, platformy, na której zachodzi interakcja, i preferencji użytkownika.

Wskazówki dotyczące tonu i stylu: Instrukcje, które dostosowują formalność, przyjazność lub poziom techniczny odpowiedzi na podstawie kontekstu konwersacji i cech użytkownika.

Planowanie wieloetapowe: W przypadku złożonych tematów systemy mogą planować odpowiedzi na wiele tur, celowo dzieląc informacje na przyswajalne fragmenty, zamiast przytłaczać użytkowników ścianami tekstu.

Integracja logiki biznesowej: Reguły, które zapewniają zgodność odpowiedzi z politykami biznesowymi, wymogami regulacyjnymi i możliwościami usług.

Najbardziej efektywne chatboty stosują również strategie adaptacyjnej odpowiedzi. Monitorują one zaangażowanie i sygnały satysfakcji użytkownika, aby z czasem udoskonalić swoje podejście do komunikacji. Jeśli użytkownicy często proszą o wyjaśnienie po pewnym typie odpowiedzi, system może automatycznie dostosować się, aby zapewnić bardziej szczegółowe wyjaśnienia w podobnych przyszłych scenariuszach.

Kluczowym aspektem generowania odpowiedzi jest zarządzanie niepewnością. Gdy informacje są niedostępne lub niejednoznaczne, dobrze zaprojektowane systemy uznają ograniczenia, zamiast generować odpowiedzi brzmiące pewnie, ale potencjalnie niepoprawne. Ta przejrzystość buduje zaufanie i skutecznie zarządza oczekiwaniami użytkowników.

W przypadku aplikacji o znaczeniu krytycznym, takich jak opieka zdrowotna lub usługi finansowe, wiele wdrożeń obejmuje mechanizmy przeglądu przez człowieka dla pewnych typów odpowiedzi, zanim dotrą one do użytkowników. Te zabezpieczenia zapewniają dodatkową warstwę kontroli jakości w przypadku interakcji o wysokiej stawce.

Moduły specjalistyczne do działań i integracji

Te możliwości działania są implementowane za pomocą specjalistycznych modułów, które łączą interfejs konwersacyjny z systemami zewnętrznymi:

Struktura integracji API: Warstwa oprogramowania pośredniczącego, która tłumaczy żądania konwersacyjne na prawidłowo sformatowane wywołania API do różnych usług zaplecza – systemów zamawiania, platform CRM, procesorów płatności, systemów rezerwacji itp.

Uwierzytelnianie i autoryzacja: Komponenty bezpieczeństwa, które weryfikują tożsamość użytkownika i poziomy uprawnień przed wykonaniem poufnych działań lub uzyskaniem dostępu do chronionych informacji.

Pomoc w wypełnianiu formularzy: Moduły, które pomagają użytkownikom wypełniać złożone formularze poprzez interakcję konwersacyjną, zbierając wymagane informacje kawałek po kawałku, zamiast prezentować przytłaczające formularze.

Przetwarzanie transakcji: Komponenty, które obsługują wieloetapowe procesy, takie jak zakupy, rezerwacje lub zmiany konta, utrzymując stan w całym procesie i obsługując wyjątki w sposób elegancki.

Systemy powiadomień: Możliwości wysyłania aktualizacji, potwierdzeń lub alertów za pośrednictwem różnych kanałów (e-mail, SMS, powiadomienia w aplikacji) w miarę postępu lub zakończenia działań.

Stopień zaawansowania tych integracji znacznie różni się w zależności od implementacji. Proste chatboty mogą obejmować podstawową funkcjonalność „przekazywania”, która przenosi użytkowników do agentów ludzkich lub wyspecjalizowanych systemów, gdy wymagane jest działanie. Bardziej zaawansowane implementacje oferują płynne doświadczenia typu end-to-end, w których chatbot obsługuje cały proces w ramach konwersacji.

Rozważmy chatbota linii lotniczych pomagającego pasażerowi zmienić lot. Musi on:

Uwierzytelnić użytkownika i pobrać jego rezerwację

Wyszukać dostępne alternatywne loty

Obliczyć wszelkie różnice w cenach lub opłaty za zmianę

Przetworzyć płatność, jeśli to konieczne

Wystawić nowe karty pokładowe

Zaktualizować rezerwację w wielu systemach

Wysłać szczegóły potwierdzenia za pośrednictwem preferowanych kanałów

Aby to osiągnąć, wymagana jest integracja z systemami rezerwacji, procesorami płatności, usługami uwierzytelniania i platformami powiadomień — wszystko to jest organizowane przez chatbota przy jednoczesnym zachowaniu naturalnego przepływu konwersacji. W przypadku firm budujących zorientowane na działanie chatboty ta warstwa integracyjna często stanowi największy wysiłek rozwojowy. Podczas gdy komponenty konwersacyjne korzystają z postępów w dziedzinie ogólnej sztucznej inteligencji, te integracje muszą być dostosowane do konkretnego krajobrazu systemowego każdej organizacji.

Kwestie bezpieczeństwa są szczególnie ważne w przypadku chatbotów zdolnych do działania. Najlepsze praktyki obejmują implementację prawidłowego uwierzytelniania przed wrażliwymi operacjami, prowadzenie szczegółowych dzienników audytu wszystkich podjętych działań, zapewnianie jasnych kroków potwierdzających dla działań następczych i projektowanie łagodnego radzenia sobie z awariami, gdy integracje napotykają problemy.

W miarę rozwoju tych możliwości integracyjnych granica między interfejsami konwersacyjnymi a tradycyjnymi aplikacjami nadal się zaciera. Najbardziej zaawansowane implementacje pozwalają użytkownikom wykonywać złożone zadania całkowicie za pomocą naturalnej konwersacji, która wcześniej wymagałaby nawigacji po wielu ekranach w tradycyjnych aplikacjach.

Szkolenia i ciągłe doskonalenie

Kilka podejść do szkolenia i doskonalenia działa w porozumieniu:

Dostrajanie modelu podstawowego: podstawowe modele językowe napędzające chatboty mogą być dalej specjalizowane poprzez dodatkowe szkolenie na danych specyficznych dla domeny. Ten proces, zwany dostrajaniem, pomaga modelowi przyjąć odpowiednią terminologię, wzorce rozumowania i wiedzę domenową dla określonych zastosowań.

Uczenie się wzmacniające na podstawie opinii zwrotnej człowieka (RLHF): ta technika wykorzystuje ludzkich ewaluatorów do oceniania odpowiedzi modelu, tworząc dane preferencji, które szkolą modele nagród. Te modele nagród następnie kierują systemem w kierunku generowania bardziej pomocnych, dokładnych i bezpiecznych wyników. RLHF odegrało kluczową rolę w przekształcaniu modeli językowych z imponujących, ale zawodnych generatorów w praktycznych asystentów.

Eksploracja konwersacji: systemy analityczne, które przetwarzają zanonimizowane dzienniki konwersacji w celu identyfikacji wzorców, typowych pytań, częstych punktów awarii i skutecznych ścieżek rozwiązywania problemów. Te spostrzeżenia napędzają zarówno automatyczne ulepszenia, jak i kierują udoskonaleniami prowadzonymi przez człowieka.

Aktywne uczenie się: Systemy, które identyfikują obszary niepewności i sygnalizują te przypadki do przeglądu przez człowieka, skupiając ludzkie wysiłki na najcenniejszych możliwościach udoskonalenia.

Testowanie A/B: Ramy eksperymentalne, które porównują różne strategie odpowiedzi z prawdziwymi użytkownikami, aby określić, które podejścia są najskuteczniejsze w różnych scenariuszach.

W przypadku chatbotów korporacyjnych proces szkolenia zwykle rozpoczyna się od danych historycznych — poprzednich transkryptów obsługi klienta, dokumentacji i informacji o produkcie. To wstępne szkolenie jest następnie uzupełniane o starannie zaprojektowane przykładowe konwersacje, które demonstrują idealne radzenie sobie z typowymi scenariuszami.

Po wdrożeniu skuteczne systemy obejmują mechanizmy sprzężenia zwrotnego, które pozwalają użytkownikom wskazać, czy odpowiedzi były pomocne. Ta informacja zwrotna w połączeniu z niejawnymi sygnałami, takimi jak porzucenie rozmowy lub powtarzające się pytania, tworzy bogaty zestaw danych do ciągłego doskonalenia.

Ludzka rola w szkoleniu nowoczesnych chatbotów pozostaje niezbędna. Projektanci konwersacji opracowują podstawową osobowość i wzorce komunikacji. Eksperci przedmiotowi sprawdzają i korygują proponowane odpowiedzi pod kątem dokładności technicznej. Naukowcy zajmujący się danymi analizują metryki wydajności, aby zidentyfikować możliwości udoskonalenia. Najbardziej udane wdrożenia traktują rozwój chatbotów jako współpracę człowieka i sztucznej inteligencji, a nie w pełni zautomatyzowany proces.

Dla firm wdrażających chatboty kluczowe jest ustanowienie jasnych ram udoskonalania. Obejmuje to:

Regularne cykle przeglądu wydajności

Dedykowany personel do monitorowania i udoskonalania

Jasne wskaźniki sukcesu

Procesy uwzględniania opinii użytkowników

Zarządzanie jakością danych szkoleniowych

Chociaż konkretne podejścia różnią się w zależności od platformy i aplikacji, podstawowa zasada pozostaje niezmienna: nowoczesne chatboty to dynamiczne systemy, które udoskonalają się poprzez użytkowanie, opinie i celowe udoskonalanie, a nie statyczne programy zamknięte w swoich początkowych możliwościach.

Zabezpieczenia i rozważania etyczne

These safeguards typically include:

Content Filtering: Systems that detect and prevent harmful, offensive, or inappropriate content in both user inputs and model outputs. Modern implementations use specialized models specifically trained to identify problematic content across various categories.

Scope Enforcement: Mechanisms that keep conversations within appropriate domains, preventing chatbots from being manipulated into providing advice or information outside their intended purpose and expertise.

Data Privacy Controls: Protections for sensitive user information, including data minimization principles, anonymization techniques, and explicit consent mechanisms for data storage or usage.

Bias Mitigation: Processes that identify and reduce unfair biases in training data and model outputs, ensuring equitable treatment across different user groups.

External Reference Verification: For factual claims, particularly in sensitive domains, systems that verify information against trusted external sources before presenting it to users.

Human Oversight: For critical applications, review mechanisms that enable human monitoring and intervention when necessary, particularly for consequential decisions or sensitive topics.

The implementation of these safeguards involves both technical and policy components. At the technical level, various filtering models, detection algorithms, and monitoring systems work together to identify problematic interactions. At the policy level, clear guidelines define appropriate use cases, required disclaimers, and escalation paths.

Healthcare chatbots provide a clear example of these principles in action. Well-designed systems in this domain typically include explicit disclaimers about their limitations, avoid diagnostic language unless medically validated, maintain strict privacy controls for health information, and include clear escalation paths to human medical professionals for appropriate concerns.

For businesses implementing chatbots, several best practices have emerged:

Start with clear ethical guidelines and use case boundaries

Implement multiple layers of safety mechanisms rather than relying on a single approach

Test extensively with diverse user groups and scenarios

Establish monitoring and incident response protocols

Provide transparent information to users about the system's capabilities and limitations

As conversational AI becomes more powerful, the importance of these safeguards only increases. The most successful implementations balance innovation with responsibility, ensuring that chatbots remain helpful tools that enhance human capabilities rather than creating new risks or harms.

The Future of Chatbot Technology

While today's chatbots have come remarkably far from their primitive ancestors, the technology continues to evolve rapidly. Several emerging trends indicate where conversational AI is headed in the near future:

Multimodal Capabilities: The next generation of chatbots will move beyond text to seamlessly incorporate images, voice, video, and interactive elements. Users will be able to show problems through their camera, hear explanations with visual aids, and interact through whatever medium is most convenient for their current context.

Agentic Behaviors: Advanced chatbots are moving from reactive question-answering to proactive problem-solving. These "agentic" systems can take initiative, break complex tasks into steps, use tools to gather information, and persist until objectives are achieved – more like virtual assistants than simple chatbots.

Memory and Personalization: Future systems will maintain more sophisticated long-term memory of user preferences, past interactions, and relationship history. This persistent understanding will enable increasingly personalized experiences that adapt to individual communication styles, knowledge levels, and needs.

Specialized Domain Experts: While general-purpose chatbots will continue to improve, we're also seeing the emergence of highly specialized systems with deep expertise in specific domains – legal assistants with comprehensive knowledge of case law, medical systems trained on clinical literature, or financial advisors versed in tax codes and regulations.

Collaborative Intelligence: The line between human and AI responsibilities will continue to blur, with more sophisticated collaboration models where chatbots and human experts work together seamlessly, each handling aspects of customer interaction where they excel.

Emotional Intelligence: Advancements in affect recognition and appropriate emotional response generation will create more naturally empathetic interactions. Future systems will better recognize subtle emotional cues and respond with appropriate sensitivity to user needs.

Federated and On-Device Processing: Privacy concerns are driving development of architectures where more processing happens locally on user devices, with less data transmitted to central servers. This approach promises better privacy protection while maintaining sophisticated capabilities.

These advancements will enable new applications across industries. In healthcare, chatbots may serve as continuous health companions, monitoring conditions and coordinating care across providers. In education, they might function as personalized tutors adapting to individual learning styles and progress. In professional services, they could become specialized research assistants that dramatically amplify human expertise.

However, these capabilities will also bring new challenges. More powerful systems will require more sophisticated safety mechanisms. Increasingly human-like interactions will raise new questions about appropriate disclosure of AI identity. And as these systems become more integrated into daily life, ensuring equitable access and preventing harmful dependencies will become important social considerations.

What seems clear is that the line between chatbots and other software interfaces will continue to blur. Natural language is simply the most intuitive interface for many human needs, and as conversational AI becomes more capable, it will increasingly become the default way we interact with digital systems. The future isn't just about better chatbots – it's about conversation becoming the primary human-computer interface for many applications.

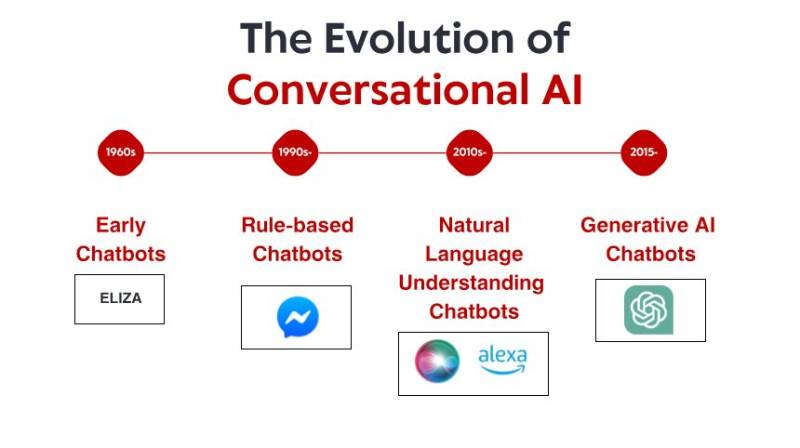

Wnioski: Trwająca rozmowa

Ta złożona architektura umożliwia doświadczenia, które jeszcze dekadę temu wydawałyby się science fiction — naturalne konwersacje z systemami cyfrowymi, które mogą odpowiadać na pytania, rozwiązywać problemy i wykonywać działania w naszym imieniu. A jednak wciąż jesteśmy na wczesnych etapach rozwoju tej technologii. Możliwości i zastosowania konwersacyjnej AI będą nadal szybko się rozwijać w nadchodzących latach.

Dla firm i organizacji, które chcą wdrożyć technologię chatbotów, zrozumienie tych podstawowych komponentów ma kluczowe znaczenie dla ustalenia realistycznych oczekiwań, podejmowania świadomych wyborów projektowych i tworzenia naprawdę wartościowych doświadczeń użytkowników. Najbardziej udane implementacje nie traktują chatbotów jako magicznych czarnych skrzynek, ale raczej jako wyrafinowane narzędzia, których możliwości i ograniczenia muszą być przemyślanie zarządzane.

Dla użytkowników wchodzących w interakcję z tymi systemami, spojrzenie za kulisy może pomóc obalić mit, który czasami wydaje się technologiczną magią. Zrozumienie podstawowych zasad działania nowoczesnych chatbotów umożliwia skuteczniejszą interakcję – wiedząc, kiedy mogą pomóc, kiedy mogą mieć problemy i jak komunikować się z nimi najskuteczniej.

Co jest być może najbardziej niezwykłe w technologii chatbotów, to to, jak szybko nasze oczekiwania się dostosowują. Funkcje, które kilka lat temu by nas zaskoczyły, szybko stają się punktem odniesienia, który bierzemy za pewnik. Ta szybka normalizacja świadczy o tym, jak naturalnie rozmowa funkcjonuje jako interfejs – gdy jest dobrze wykonana, po prostu znika, pozostawiając nas skupionych na rozwiązywaniu problemów i wykonywaniu zadań, zamiast myśleć o samej technologii.

W miarę rozwoju tych systemów rozmowa między ludźmi a maszynami będzie stawać się coraz bardziej płynna i produktywna – nie zastępując ludzkiego połączenia, ale zwiększając nasze możliwości i uwalniając nas, abyśmy mogli skupić się na wyjątkowo ludzkich aspektach naszej pracy i życia.