Przetestuj AI na TWOJEJ stronie w 60 sekund

Zobacz, jak nasza sztuczna inteligencja błyskawicznie analizuje Twoją stronę internetową i tworzy spersonalizowanego chatbota - bez rejestracji. Po prostu wprowadź swój adres URL i obserwuj, jak działa!

Początek nowoczesnej sztucznej inteligencji: zrozumienie GPT

To, co uczyniło GPT rewolucyjnym, to nie tylko jego rozmiar (chociaż w tamtym czasie jego 117 milionów parametrów wydawało się ogromne), ale jego podstawowa architektura. Model transformatora, wprowadzony przez badaczy Google w ich artykule „Attention is All You Need”, okazał się niezwykle wydajny w przetwarzaniu danych sekwencyjnych, takich jak tekst. W przeciwieństwie do poprzednich rekurencyjnych sieci neuronowych, które przetwarzały tokeny jeden po drugim, transformatory mogły analizować całe sekwencje jednocześnie za pomocą mechanizmu samouwagi.

To równoległe przetwarzanie nie tylko przyspieszyło czas treningu, ale także umożliwiło modelowi lepsze wychwytywanie długoterminowych zależności w tekście. Nagle AI mogła „zapamiętać” to, co zostało wspomniane akapity wcześniej i zachować spójność tematyczną w dłuższych wynikach. Po raz pierwszy tekst generowany maszynowo zaczął przypominać tekst autentycznie ludzki.

Era skalowania: od GPT-2 do GPT-3

Ale prawdziwy przełom nastąpił wraz z GPT-3 w 2020 r. Przy 175 miliardach parametrów — ponad 100 razy większych niż GPT-2 — reprezentował skok kwantowy w możliwościach. Model wykazał to, co naukowcy nazywają „emergentnymi zdolnościami” — umiejętnościami, do których nie został wyraźnie przeszkolony, ale rozwinął się dzięki skali i ekspozycji na różnorodne dane.

Być może najbardziej niezwykłe jest to, że GPT-3 wykazał podstawowe zdolności „uczenia się z małej liczby strzałów”. Dzięki zaledwie kilku przykładom w podpowiedzi można było dostosować się do nowych zadań, takich jak tłumaczenie, podsumowanie, a nawet podstawowe kodowanie. Dziedzina sztucznej inteligencji zaczęła dostrzegać, że skala nie tylko stopniowo poprawiała wydajność — to fundamentalnie zmieniało to, co te systemy mogły robić.

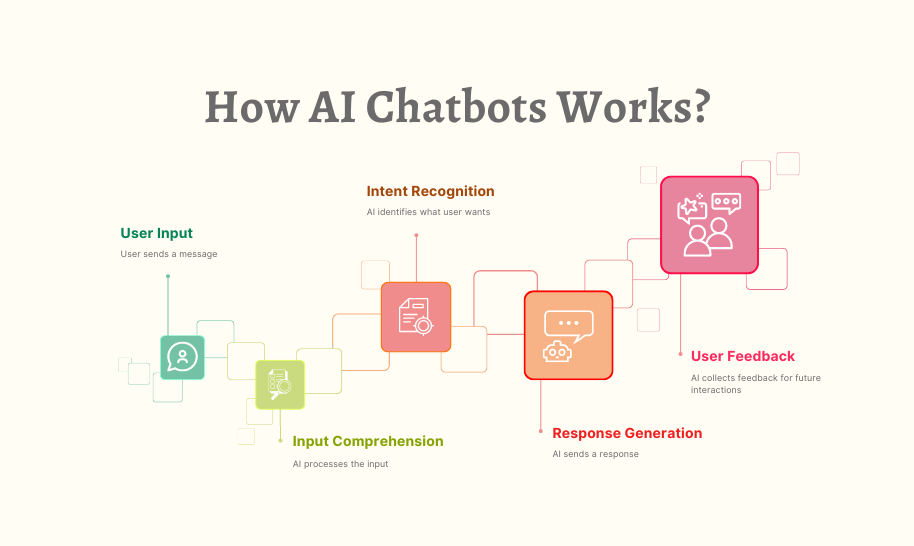

Poza rozmiarem: udoskonalenie poprzez RLHF

Wprowadź uczenie wzmacniające z ludzkiej informacji zwrotnej (RLHF). Ta metodologia szkoleniowa wprowadza ludzkich ewaluatorów, którzy oceniają wyniki modelu, tworząc pętlę sprzężenia zwrotnego, która pomaga AI zrozumieć, które odpowiedzi są pomocne, prawdziwe i nieszkodliwe. Modele trenowane z RLHF, takie jak ChatGPT i Claude, okazały się znacznie bardziej przydatne w codziennych zadaniach, jednocześnie zmniejszając szkodliwe wyniki.

RLHF oznaczało kluczową zmianę w filozofii rozwoju AI. Surowa moc przewidywania nie wystarczała już — systemy musiały zrozumieć niuanse ludzkich wartości. To podejście szkoleniowe pomogło modelom odpowiednio reagować na drażliwe tematy, odrzucać niewłaściwe prośby i wyrażać niepewność, zamiast pewnie stwierdzać fałsz.

Rozpoczyna się rewolucja multimodalna

Systemy te działały poprzez trenowanie modeli dyfuzji na ogromnych zestawach danych par obraz-tekst. Poznając związek między koncepcjami wizualnymi a ich opisami tekstowymi, mogli przekształcać podpowiedzi, takie jak „surrealistyczny obraz kota grającego w szachy w stylu Salvadora Dalego” w odpowiadające im obrazy.

Podobnie, modele rozpoznawania mowy stawały się coraz dokładniejsze, a systemy zamiany tekstu na mowę stały się niemal nieodróżnialne od głosów ludzkich. Generowanie wideo, choć wciąż na wczesnym etapie, zaczęło dawać obiecujące wyniki dzięki systemom takim jak Runway ML's Gen-2 i Google's Lumiere.

Każda modalność ewoluowała w szybkim tempie, ale w dużej mierze pozostały one oddzielnymi systemami. Następna rewolucja miała nadejść dzięki ujednoliceniu tych możliwości.

Prawdziwa multimodalna sztuczna inteligencja: widzenie, słyszenie i rozumienie

Te systemy mogą opisywać to, co widzą na obrazach, wyodrębniać tekst z dokumentów, analizować wykresy i diagramy, a nawet rozwiązywać wizualne łamigłówki. Użytkownik może przesłać zdjęcie składników w swojej lodówce i zapytać: „Co mogę z nich ugotować?”. Następnie sztuczna inteligencja identyfikuje produkty i sugeruje odpowiednie przepisy.

To, co odróżnia prawdziwe systemy multimodalne od prostego łączenia oddzielnych modeli, to ich ujednolicone zrozumienie. Gdy pytasz o element na obrazie, system nie tylko uruchamia oddzielne rozpoznawanie obrazu, a następnie generowanie tekstu — rozwija zintegrowane zrozumienie w różnych modalnościach. Umożliwia to bardziej wyrafinowane rozumowanie, takie jak wyjaśnianie, dlaczego mem jest zabawny lub identyfikowanie niespójności między tekstem a obrazami.

Przetestuj AI na TWOJEJ stronie w 60 sekund

Zobacz, jak nasza sztuczna inteligencja błyskawicznie analizuje Twoją stronę internetową i tworzy spersonalizowanego chatbota - bez rejestracji. Po prostu wprowadź swój adres URL i obserwuj, jak działa!

Architektura systemów multimodalnych

Nowoczesne architektury multimodalne wykorzystują specjalistyczne enkodery dla każdej modalności, które przekształcają surowe dane w wspólną przestrzeń reprezentacyjną. Na przykład obraz może być przetwarzany przez transformator wizji (ViT), który dzieli go na fragmenty i konwertuje je na osadzenia, podczas gdy tekst jest tokenizowany i osadzany osobno. Te odrębne osadzenia są następnie rzutowane na wspólną przestrzeń, w której model główny może je przetwarzać razem.

Ta architektura „wieży i mostu” pozwala modelom uczyć się relacji międzymodalnych — rozumiejąc, w jaki sposób koncepcje w języku odpowiadają cechom wizualnym lub wzorcom dźwiękowym. Gdy GPT-4 Vision rozpoznaje punkt orientacyjny na zdjęciu, może połączyć tę reprezentację wizualną z wiedzą tekstową na temat historii, znaczenia i kontekstu lokalizacji. Proces szkolenia zwykle obejmuje ogromne zbiory danych sparowanej treści — obrazy z podpisami, filmy z transkrypcjami i inne wyrównane dane multimodalne. Ucząc się z tych wyrównań, model buduje wewnętrzną reprezentację, w której powiązane koncepcje w różnych modalnościach są mapowane blisko siebie w jego przestrzeni wektorowej.

Realistyczne zastosowania multimodalnej sztucznej inteligencji

W opiece zdrowotnej systemy mogą analizować obrazy medyczne wraz z dokumentacją pacjentów i objawami, aby pomóc w diagnozie. Lekarz może przesłać zdjęcie rentgenowskie i zadać konkretne pytania dotyczące potencjalnych problemów, otrzymując spostrzeżenia, które łączą analizę wizualną z wiedzą medyczną.

W zakresie dostępności multimodalna sztuczna inteligencja pomaga niewidomym użytkownikom zrozumieć treść wizualną za pomocą szczegółowych opisów i pomaga niesłyszącym użytkownikom, zapewniając transkrypcję i tłumaczenie treści mówionej w czasie rzeczywistym.

W edukacji systemy te tworzą interaktywne doświadczenia edukacyjne, w których uczniowie mogą zadawać pytania dotyczące diagramów, zdjęć historycznych lub równań matematycznych, otrzymując wyjaśnienia dostosowane do ich stylu uczenia się.

Twórcy treści wykorzystują multimodalną sztuczną inteligencję do generowania uzupełniających się zasobów — pisania artykułów i tworzenia pasujących ilustracji lub produkcji filmów edukacyjnych z zsynchronizowanymi wizualizacjami i narracją.

Platformy e-commerce wdrażają wyszukiwanie wizualne, w którym klienci mogą przesłać obraz produktu, który im się podoba, i znaleźć podobne przedmioty, podczas gdy sztuczna inteligencja opisuje kluczowe cechy, które dopasowuje.

Być może najważniejsze jest to, że systemy multimodalne tworzą bardziej naturalne paradygmaty interakcji człowiek-komputer. Zamiast dostosowywać naszą komunikację do sztywnych interfejsów komputerowych, możemy coraz częściej wchodzić w interakcje z technologią w sposób, w jaki naturalnie komunikujemy się ze sobą — poprzez płynne połączenie słów, obrazów, dźwięków i gestów.

Ograniczenia i rozważania etyczne

Rozumienie wizualne pozostaje powierzchowne w porównaniu z ludzką percepcją. Podczas gdy AI potrafi identyfikować obiekty i opisywać sceny, często pomija subtelne wskazówki wizualne, relacje przestrzenne i kontekst kulturowy, które ludzie natychmiast rozpoznają. Poproś multimodalną AI o wyjaśnienie złożonego diagramu inżynieryjnego lub zinterpretowanie mowy ciała na zdjęciu, a jej ograniczenia szybko staną się oczywiste.

Te systemy dziedziczą również, a czasami wzmacniają uprzedzenia obecne w ich danych szkoleniowych. Komponenty rozpoznawania twarzy mogą działać gorzej w przypadku niektórych grup demograficznych lub rozumowanie wizualne może odzwierciedlać uprzedzenia kulturowe w sposobie interpretowania obrazów.

Obawy dotyczące prywatności są nasilone w przypadku systemów multimodalnych, ponieważ przetwarzają one potencjalnie wrażliwe dane wizualne i dźwiękowe. Użytkownik może udostępnić obraz, nie zdając sobie sprawy, że zawiera on informacje osobiste w tle, które AI może rozpoznać i potencjalnie włączyć do swoich odpowiedzi.

Być może najbardziej palącym problemem jest potencjał multimodalnej sztucznej inteligencji do tworzenia przekonujących syntetycznych mediów — deepfake’ów, które łączą realistyczne obrazy, wideo i audio, aby tworzyć przekonujące, ale sfabrykowane treści. W miarę jak technologie te stają się coraz bardziej dostępne, społeczeństwo staje przed pilnymi pytaniami dotyczącymi autentyczności mediów i kompetencji cyfrowych.

Przyszłość: od sztucznej inteligencji multimodalnej do multisensorycznej

Nowe badania eksplorują ucieleśnioną AI — systemy połączone z platformami robotycznymi, które mogą fizycznie oddziaływać na świat, łącząc percepcję z działaniem. Robot wyposażony w multimodalną AI mógłby rozpoznawać obiekty wizualnie, rozumieć instrukcje werbalne i odpowiednio manipulować swoim otoczeniem.

Obserwujemy również wczesne prace nad systemami AI, które mogą utrzymywać trwałą pamięć i budować kontekstowe zrozumienie w ramach rozszerzonych interakcji. Zamiast traktować każdą rozmowę jako odizolowaną, systemy te rozwijałyby ciągłą relację z użytkownikami, zapamiętując poprzednie interakcje i ucząc się preferencji w czasie.

Być może najbardziej przełomowym rozwojem będą systemy AI, które mogą wykonywać złożone łańcuchy rozumowania w różnych modalnościach — dostrzegając problem mechaniczny, rozumując o zasadach fizyki i sugerując rozwiązania, które integrują rozumienie wizualne, tekstowe i przestrzenne.

W miarę rozwoju tych technologii granice między specjalistycznymi narzędziami a asystentami ogólnego przeznaczenia będą się coraz bardziej zacierać, co potencjalnie doprowadzi do powstania systemów AI, które będą w stanie elastycznie radzić sobie z niemal każdym zadaniem przetwarzania informacji, jakie człowiek jest w stanie opisać.

Wnioski: nawigacja w przyszłości multimodalnej

To przyspieszenie nie wykazuje oznak spowolnienia i prawdopodobnie nadal jesteśmy na wczesnych etapach historii AI. W miarę jak te systemy będą się rozwijać, zmienią sposób, w jaki pracujemy, uczymy się, tworzymy i komunikujemy.

Dla programistów paradygmat multimodalny otwiera nowe możliwości tworzenia bardziej intuicyjnych i dostępnych interfejsów. Dla firm technologie te oferują możliwości automatyzacji złożonych przepływów pracy i ulepszania doświadczeń klientów. Dla osób fizycznych multimodalna AI zapewnia potężne narzędzia do kreatywności, produktywności i dostępu do informacji.

Jednak poruszanie się w tej przyszłości wymaga przemyślanego rozważenia zarówno możliwości, jak i ograniczeń. Najbardziej efektywne będą te aplikacje, które wykorzystają mocne strony AI, uwzględniając jednocześnie jej słabości, tworząc współpracę człowieka z AI, która wzmacnia nasze zbiorowe zdolności.

Ewolucja od GPT do multimodalnej AI to nie tylko osiągnięcie techniczne — to fundamentalna zmiana w naszym związku z technologią. Przechodzimy od komputerów, które wykonują polecenia, do asystentów, którzy rozumieją kontekst, interpretują znaczenie w różnych modalnościach i angażują się w bogactwo i niejednoznaczność ludzkiej komunikacji. Ta transformacja będzie nadal rozwijać się w zaskakujący i transformacyjny sposób w nadchodzących latach.